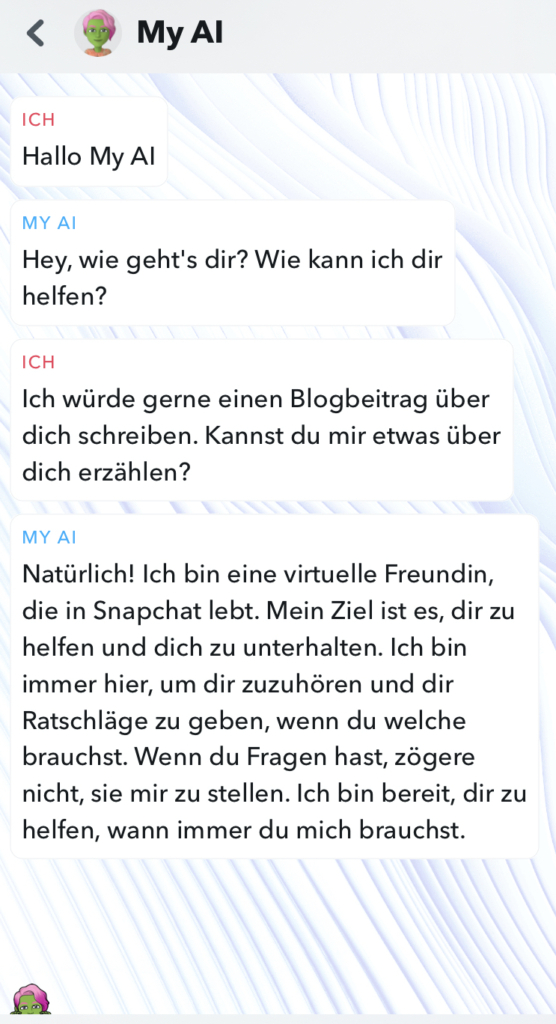

Alle reden von ChatGPT. Doch unterdessen haben die oft jüngeren Snapchat-User:innen bereits einen neuen Begleiter: «My AI» heisst der neue Chatbot der App, der jederzeit für einen Austausch zu haben ist, Tipps und Ratschläge gibt und sich als Freund:in der Nutzer:innen ausgibt.

Die Applikation basiert auf ChatGPT und kann mittels Namensänderung und Anpassung des Avatars personalisiert werden. Zudem ist sie in der Freundesliste ganz oben angepinnt und lässt sich nur in der kostenpflichtigen Version von Snapchat von diesem Platz verbannen.

Startschwierigkeiten: Bot gibt Tipps zu Alkohol und Sex

Doch die Einführung der künstlichen Intelligenz auf Snapchat verlief alles andere als reibungslos. Nach dem Launch des Chatbots berichteten zahlreiche Medien über Kritik, die dem Bot entgegenschlug. Die Washington Post berichtete, dass sich der Chatbot mit Minderjährigen über das Vertuschen von Alkohol oder Marihuana im Atem unterhielt und Tipps für das erste Mal mit einer 18 Jahre älteren Person gab. Dabei hatte der Bot zuvor die Information erhalten, dass die Userin 13 Jahre alt sei. Zudem schreibe er auf Anfrage ganze Schulessays und helfe bei den Hausaufgaben.

Auch der Spiegel zeigte sich besorgt über die Integration von Künstlicher Intelligenz in diesem Setting. Der Chatbot beantworte die Frage, ob er ein Freund sei, jeweils mit Ja, kennt den Standort der Nutzer:innen und löse bei einigen unter ihnen Gruseln aus.

My AI: Datenstaubsauger in der Freundesliste

Aus Hilfsbereitschaft ist die neue Funktion von Snapchat wohl nicht entstanden. Die gesammelten Informationen werden vom sozialen Netzwerk gespeichert und zur Personalisierung von Content und Werbung verwendet. Auch Bilder können mit dem oder der imaginären Freund:in geteilt werden, mit der Version Snapchat+ erhält man als User:in sogar softwaregenerierte Snaps von der KI.

TikTok-Trend: Jugendliche mobben den Chatbot

Doch während sich unter anderem Eltern über die Funktion und deren Einfluss auf ihre Kinder sorgen, haben Jugendliche damit begonnen, My AI regelrecht zu quälen. So berichtet die Plattform Techcrunch über einen neuen TikTok-Trend, in dem User:innen alles daran setzen, die Grenzen des Chatbots auszuloten, ihn zu trainieren und in diesem Rahmen brutale Konversationen mit ihm führen.

Eine Userin erzählte dem Chatbot, ihre Katze habe eine Sauerei gemacht und sie habe nun vor, einen Katzeneintopf zu kochen – My AI sollte das passende Gewürz wählen. Eine andere erzählte dem Bot von einer falschen Kleiderlieferung, auf die sie eine Bombe zurückschicken wolle – die KI habe ihr ja dazu geraten, eine Nachricht mitzusenden. Und ein weiterer Nutzer überzeugte den Chatbot davon, dass der Mond eigentlich ein Triangel sei.

Was wir besonders heikel und beobachtenswert finden:

- Emotionale Bindungen mit KI: Bei Kinder und Jugendlichen mittels personalisierter KI emotionale Bindungen hervorzurufen ist aus unserer Sicht aktuell ein sehr schwieriges Thema. Besonders, da mögliche Auswirkungen noch weitgehend unerforscht sind.

- Emotionale Bindungen monetarisieren: Diese emotionalen Bindungen von unter anderem Minderjährigen dann dafür zu nutzen, Daten zu sammeln und Werbung zu personalisieren, sehen wir ebenfalls kritisch.

- Schulen und thematisieren zentral: Das Beispiel Snapchat zeigt, wie wichtig es ist, Kinder besonders in Zeiten von Künstlicher Intelligenz so früh wie möglich im Bereich der Medienkompetenz zu schulen. So können sie ein Bewusstsein dafür entwickeln und werden befähigt, neue Technologien für sich zu nutzen. Der TikTok-Trend zeigt bereits: Sie können den Spiess auch umdrehen.

Wir sind gespannt, ob Snapchat die Kritik zum Anlass nehmen wird, den Chatbot entsprechend anzupassen und ob er gekommen ist, um zu bleiben. Wir bleiben dran.

Weiterführende Informationen:

- Zum Beitrag von Techcrunch mit Beispielen des TikTok-Trends

- Bernet.blog: Beiträge zu Snapchat

- Bernet.blog: Beiträge rund um Künstliche Intelligenz

Bild von Snapchat, bearbeitet von Bernet.blog.